Mehr Autonomie durch smarte Umfeldsensorik und KI-Kameras

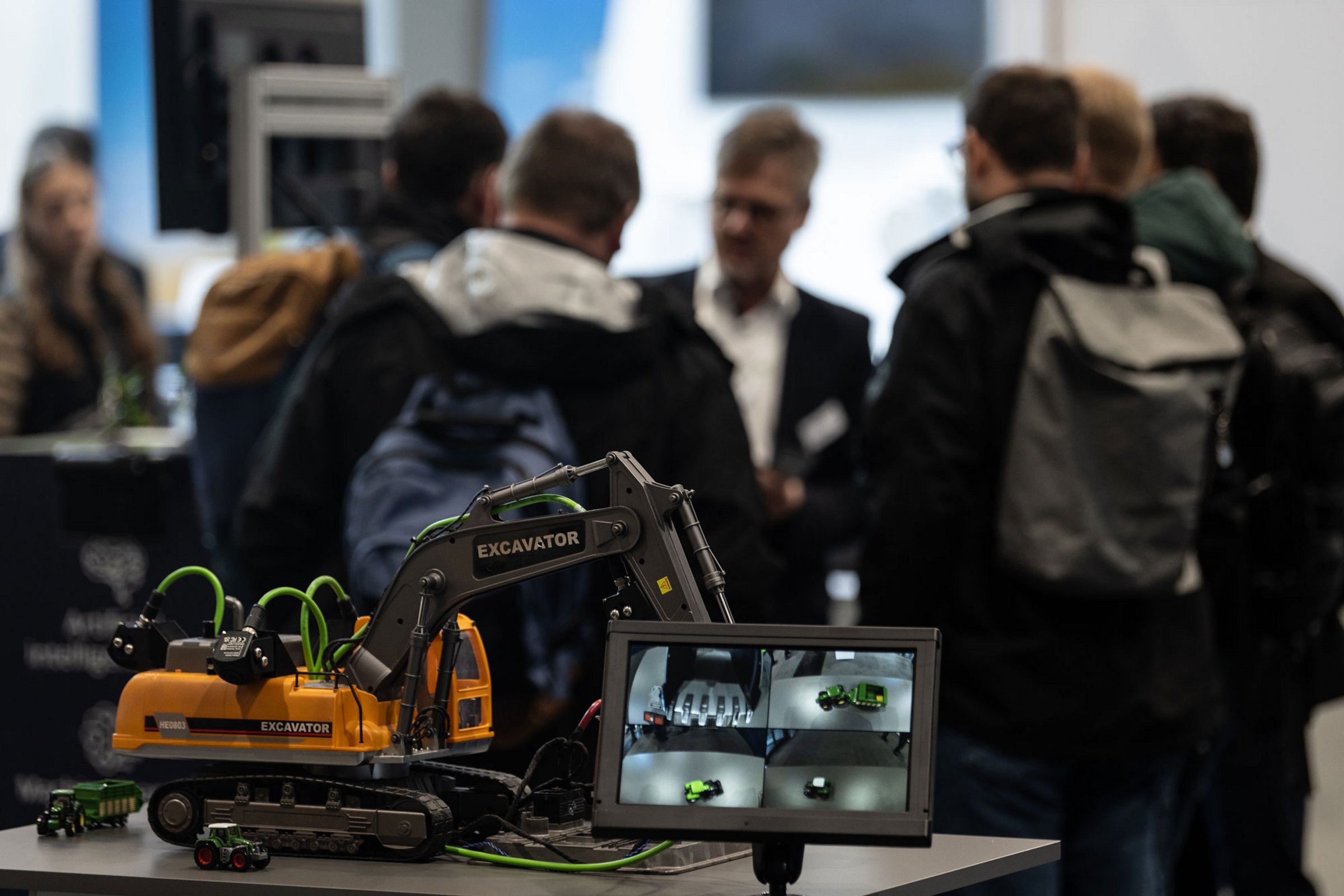

Ob auf der Baustelle oder dem Acker: Die Anforderungen bei der Automatisierung im Off-Highway-Bereich sind breit gefächert. Um die Hürden zu meistern, machen sich die Aussteller der SYSTEMS & COMPONENTS 2025 das volle Potenzial intelligenter Sensoren und Kamerasysteme zunutze – und schaffen damit wichtige technologische Voraussetzungen für die autonome mobile Arbeitsmaschine.Die vom 9. bis 15. November auf dem Messegelände in Hannover präsentierten Assistenzfunktionen können so für mehr Sicherheit und Präzision im täglichen Einsatz sorgen.

Wenn sich die Türen zur diesjährigen SYSTEMS & COMPONENTS in Hannover öffnen, trifft sich das Who’s who der Off-Highway-Branche. Auf der B2B-Plattform, die erneut im Rahmen der Agritechnica 2025 stattfindet, dreht sich alles um Komponenten, Systeme und Lösungen für die mobilen Arbeitsmaschinen von heute und morgen. Dabei zeigt sich: Es ist vor allem der rasante Fortschritt in der Automatisierung, der gegenwärtig den Innovationsgrad treibt. „Die intelligente Vernetzung und Digitalisierung innerhalb und außerhalb der Maschinen spielen eine immer wichtigere Rolle“, bestätigt Petra Kaiser von der DLG (Deutsche Landwirtschafts-Gesellschaft). Cloud-basierte Vernetzung, kabellose Maschine-zu-Maschine-Kommunikation und leistungsfähige Assistenzfunktionen zählen für die Brand Managerin der SYSTEMS & COMPONENTS zu den zentralen Trends, die sich auf dem Messegelände in Hannover widerspiegeln.

Der offensichtliche Nutzen von Assistenzsystemen veranlasst immer mehr Hersteller, smarte Sensoren und Kamerasysteme in ihre Land- und Forstmaschinen sowie Bau- und Bergbaumaschinen zu integrieren – so entstehen Lösungen, die den Wünschen nach besserer Verfügbarkeit und gesteigerter Produktivität gerecht werden. Zu den Hauptaufgaben von Sensoren gehören Umfelderfassung und Assistenzlösungen, Motion Control und Positionierung sowie funktionale Sicherheit. Letztere ist Bestandteil und Pflichtaufgabe zahlreicher Entwicklungen, die auf der SYSTEMS & COMPONENTS präsentiert werden.

Flexibler Sensorbaukasten für Assistenzsysteme

Doch wer gibt die Sicherheit, dass die Bewegungsabläufe in den Maschinen wirklich präzise sind? Gefordert sind im Außeneinsatz robuste Sensoren und Kameras, die unter rauen Umgebungsbedingungen wie Nebel, starkem Regen, Schnee und Staub zuverlässig arbeiten und für eine ungehinderte Rundumsicht der Fahrzeugführer sorgen. Hierfür bieten die Aussteller ein umfangreiches Portfolio: 3D-Streaming-Kameras, LiDAR-Sensoren oder Laserscanner, Neigungssensoren, Encoder und induktive Näherungssensoren – zur Auswahl steht eine große Bandbreite an Technologien, die sich flexibel und maßgeschneidert auf die spezifischen Anwendungen und Assistenzfunktionen abstimmen lassen.

Hinzu kommen Nahbereichs-Ultraschallsensoren. Sie funktionieren nach dem Echolotprinzip und eignen sich für die Überwachung des Arbeitsbereichs mobiler Maschinen. Sie geben dem Bediener im Cockpit die notwendigen Rückmeldungen zur Bestimmung der Position und Ausrichtung von angebauten Werkzeugen. Ultraschallsensoren wie etwa der UF401V von Baumer können auch vorübergehende Störungen in der Distanzmessung unterdrücken und so kontinuierliche Daten liefern – selbst wenn sich Pflanzenteile kurz zwischen Sensor und Messfläche schieben. Seine Stärken spielt der Sensor besonders in landwirtschaftlichen Anwendungen aus. Mit seinen kurzen Reaktionszeiten eignet er sich für agile Anwendungen wie Präsenzkontrolle von Ballen, Ballenfolie und Distanzmessungen. Der UF401V kann ebenso für hydraulisch betätigte Maschinenteile verwendet werden, die eine Positionsrückmeldung benötigen. Beispielsweise liefert er zuverlässig Daten, um Spurweiten und Sprayerhöhen präzise zu erfassen.

Mehr Fahrsicherheit mit Künstlicher Intelligenz

Ob Rückraumüberwachung, Arbeitsraumüberwachung oder Seitenraumüberwachung: Den Akteuren der Off-Highway-Märkte ist bewusst, wie kritisch die valide Datenerfassung ist. Sie ist insbesondere dann wichtig, wenn es um maschinelles Sehen und KI geht – so lässt sich der GIGO-Effekt (Garbage In, Garbage Out) vermeiden, der besagt, dass die Qualität der Ausgabedaten direkt von der Qualität der Eingabedaten abhängt. Zunehmend konzentrieren sich die Technologieanbieter deshalb auf die Schlüsselbereiche Deep Learning, 3D-Erkennung und Embedded Vision. Diese Technologien sollen dabei helfen, die Off-Highway-Maschinen auf die nächste Entwicklungsstufe zu heben.

Christian Klausner, Director Product Management bei Sensor-Technik Wiedemann (STW), weiß um die Herausforderungen bei der Entwicklung: „Solange ein Maschinenführer auf dem Fahrzeug sitzt, ist die funktionale Sicherheit zwar auch wichtig, aber nicht so entscheidend wie beispielsweise bei der Feldrobotik.“ Denn diese Roboter benötigen eine (KI-basierte) Umfelderkennung und kompatible Aktor- und Fahrsysteme, die selbständig erkennen und entscheiden, wann eine unsichere Situation entsteht, um entsprechende Gegenmaßnahmen zu ergreifen. Moderne 3D-LiDAR-Sensoren sorgen dafür, dass die Roboter die komplizierte Topografie eines typischen Agrarfeldes erfassen können. Gegenüber Radar hat LiDAR (Light Detection and Ranging) den Vorteil, dass es auch auf lange Distanz hochauflösende 3D-Informationen in Echtzeit liefert.

Sensorfusion auf dem Vormarsch

Die größte Herausforderung bei der Weiterentwicklung von Assistenzfunktionen besteht in der Vielfalt der Konzepte und möglichen Systemarchitekturen. Wurde LiDAR vor einigen Jahren noch als Konkurrenz zu Kamera oder Radar gesehen, stimmen Off-Highway-Experten heute darin überein, dass die Frage nach dem Einsatz dieser Systeme nicht mit einem Entweder-oder, sondern mit Sowohl-als-auch beantwortet werden sollte. „Letztlich wird nur eine Fusion der verschiedenen Technologien die notwendige Sicherheit für vollständig autonom agierende Bau- und Landmaschinen liefern können“, sagt Petra Kaiser von der DLG. Ermöglicht werden diese Entwicklungen nicht zuletzt durch die jüngste Generation an Hochleistungsprozessoren, die 2D- und 3D-Daten direkt im Sensor fusionieren. So werden Informationen gewonnen, die einzelne Sensoren nicht bereitstellen können.

Beispielhaft für diesen Trend steht das Smart-Sensor-System O3M AI von ifm. Es generiert ein Video, das die Umgebung wiedergibt und dabei gleichzeitig Informationen zu den exakten Distanzen aller Objekte und Personen im Umkreis von bis zu 25 Metern einblendet. Möglich wird dies durch die Kombination von 3D-PMD-Sensor und 2D-KI-Kamera zu einem Embedded-System für die Bereichsraumüberwachung. PMD steht für Photonic Mixer Device. Das Besondere: Die Messung funktioniert unabhängig von der Farbe der Oberfläche. Durch die Sensordatenfusion zweier unterschiedlicher Sensortypen auf einer vollintegrierten und fertig kalibrierten Plattform gewinnt das System deutlich an Zuverlässigkeit. Mit der sinkenden Anzahl der Fehlalarme steigt auch die Effizienz des Arbeitsprozesses. Das System kann jederzeit differenzieren, ob eine Notbremsung, ein kontrolliertes Anhalten oder eine Verlangsamung in der jeweiligen Situation angemessen ist, denn es erkennt mit einer Genauigkeit von zehn Zentimetern, ob sich eine Person im näheren Umfeld befindet – selbst, wenn diese auf dem Boden liegt, dunkle Kleidung trägt oder durch größere Werkzeuge nur schwer zu erkennen ist.

Autonomie wird für mehr Maschinen verfügbar

Die sensorbasierten Assistenzfunktionen sind ein wichtiger und logischer nächster Schritt in Richtung Vollautomatisierung. Und damit eine Antwort auf eine der größten Herausforderungen im Off-Highway-Bereich: den Mangel an Fahrern und Fachkräften „Bei unseren Kunden aus Landwirtschaft, Baugewerbe und gewerblichem Landschaftsbau fallen Arbeiten an, die zu bestimmten Tages- und Jahreszeiten erledigt werden müssen, für die es aber nicht genügend verfügbare und qualifizierte Arbeitskräfte gibt“, bestätigt Jahmy Hindman, Chief Technology Officer bei John Deere. „Deshalb erweitern wir unser Technologie-Portfolio, damit mehr Maschinen in komplexen Umgebungen sicher und autonom arbeiten können.“

Das Anfang des Jahres von John Deere vorgestellte Autonomiepaket der zweiten Generation kombiniert fortschrittliche Bilderkennung, KI und Kameras, um die Maschinen im Rahmen der Präzisionslandwirtschaft zu unterstützen. Ausgestattet mit 16 Einzelkameras, die eine 360-Grad-Sicht auf das Feld ermöglichen, gewährleistet es den autonomen Einsatz eines 9RX Traktors. So können sich die Landwirte von der Maschine entfernen und sich auf andere wichtige Aufgaben konzentrieren. Zu den möglichen Szenarien zählt auch der Einsatz von Pflanzenschutzmitteln im Obstanbau. Hierfür wurde der Schmalspurtraktor 5ML mit dem Autonomiepaket sowie zusätzlichen LiDAR-Sensoren ausgestattet, die den schlechteren Lichtverhältnissen in Obstplantagen Rechnung tragen. Der Ausblick auf die SYSTEMS & COMPONENTS zeigt: Für die Vision der vollautomatisierten mobilen Arbeitsmaschine bieten die vom 9. bis 15. November in Hannover ausstellenden Unternehmen bereits heute diverse Lösungen. Die kontinuierliche Weiterentwicklung der Umfeldsensorik und Multikamerasysteme wird in den kommenden Jahren zahlreiche Anwendungen für innovative Assistenzfunktionen mit sich bringen.